Cómo se ven los retrasos de indexación cuando publicas mucho

Los retrasos de indexación suelen seguir el mismo patrón: publicas, la página está en vivo, pero no aparece en búsqueda durante días (a veces semanas). Con poco volumen, ese retraso pasa desapercibido. Cuando publicas docenas de URLs al día, el retraso se hace evidente porque las páginas nuevas se acumulan más rápido de lo que entran en el índice.

Un signo común es un estado en Search Console como "Crawled, currently not indexed." Eso significa que un bot visitó la URL, pero no la almacenó como resultado buscable. Otro patrón: solo una porción de tus páginas más nuevas se indexa, mientras que áreas más antiguas del sitio siguen rindiendo con normalidad.

Cuando saltas de 10 páginas a 1.000+, los crawlers tienen que elegir dónde invertir tiempo. Si tu sitio genera muchas URLs similares (duplicados, páginas delgadas, variantes con parámetros), los bots pueden malgastar visitas en lo equivocado. Las páginas que realmente te importan terminan esperando.

Los problemas frecuentes detrás de "crawled but not indexed" en sitios de alto volumen suelen reducirse a unas causas:

- La página parece demasiado parecida a otras existentes (plantillas reutilizadas, intros repetidas, temas casi duplicados).

- La página parece poco importante (pocos enlaces internos, enterrada en paginación).

- La página envía señales técnicas mixtas (canonical erróneo,

noindex accidental, recursos bloqueados).

- El sitio genera demasiadas URLs de bajo valor (filtros, parámetros de seguimiento, navegación facetada).

- El contenido no satisface la consulta (delgado, desactualizado o sin detalles clave).

Una forma rápida de distinguir problemas de calidad de problemas de descubrimiento es muestrear un lote pequeño de URLs nuevas (por ejemplo 20) y hacer dos preguntas.

Primero: ¿puede un crawler descubrirla fácilmente? Confirma que la URL está en tu sitemap XML, tiene al menos un enlace interno prominente, devuelve 200 OK y no está bloqueada por reglas de robots.

Segundo: si se descubre, ¿vale la pena indexarla? Busca verdadera unicidad (no es una reescritura de una página existente), coincidencia clara de intención (responde una pregunta real) y suficiente sustancia (detalles y ejemplos, no solo una plantilla).

Si la mayoría de tu muestra falla la primera pregunta, tienes un problema de sistema de descubrimiento. Si pasan el descubrimiento pero fallan la segunda, tienes un problema de calidad y duplicación. Arregla lo correcto y el backlog suele reducirse rápido.

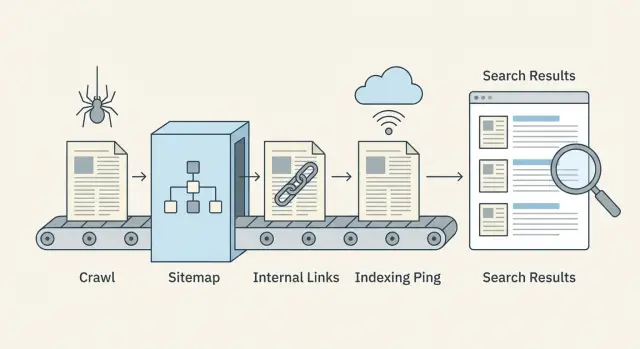

El flujo de rastreo a indexación en lenguaje llano

Publicar no hace que una página sea inmediatamente buscable. Los motores la mueven por una tubería, y los retrasos pueden ocurrir en cualquier paso.

Descubrimiento, rastreo e indexación (qué significan)

Descubrimiento es cuando un motor de búsqueda sabe que existe una URL. Eso suele ocurrir por enlaces internos, tu sitemap XML o una mención externa.

Rastreo es cuando un bot visita la URL y descarga lo que ve (HTML, recursos clave y a veces URLs vinculadas adicionales). El rastreo está limitado por tiempo y atención, así que algunas páginas se visitan tarde o raramente.

Indexación es cuando el motor decide si almacenar la página y mostrarla en resultados, y para qué consultas. Una página rastreada no está garantizada para indexarse.

El flujo se ve así:

- El motor encuentra la URL (descubrimiento)

- El bot recupera la página (rastreo)

- La página se evalúa y se almacena o se omite (indexación)

- Los rankings se actualizan con el tiempo a medida que las señales se acumulan

Dónde suelen suceder los retrasos

La mayoría de las lentitudes ocurren antes de que el bot llegue a la página, o justo después de que la rastrea.

Los retrasos de descubrimiento aparecen cuando las páginas nuevas están huérfanas (sin enlaces que apunten a ellas) o cuando los sitemaps están desactualizados.

Los retrasos de rastreo a menudo vienen de desperdiciar crawls en URLs de bajo valor (rutas duplicadas, páginas facetadas, spam de parámetros) o de respuestas lentas del servidor.

Los retrasos de indexación ocurren cuando las páginas parecen demasiado similares a otras, tienen contenido delgado, envían señales mixtas (canonical apuntando a otro lugar, noindex accidental) o cargan contenido clave tarde.

Señales que puedes cambiar rápido vs lento

Palancas rápidas son mayormente técnicas y estructurales: enlaces internos más fuertes desde páginas ya rastreadas, sitemaps precisos, menos trampas de rastreo, mejores tiempos de respuesta y pings de indexación proactivos cuando tienen sentido.

Palancas lentas toman tiempo: calidad general del sitio, consistencia, enlaces ganados y señales de engagement a largo plazo.

Qué medir semanalmente

No necesitas un tablero complejo para detectar problemas temprano. Controla un conjunto pequeño de números cada semana:

- Nuevas URLs publicadas vs nuevas URLs indexadas

- Tiempo mediano desde la publicación hasta el primer rastreo

- Errores de rastreo y respuestas lentas (5xx, timeouts)

- Porcentaje de "Discovered, currently not indexed" y "Crawled, currently not indexed"

- Cobertura del sitemap: URLs en el sitemap vs URLs realmente indexables

Presupuesto de rastreo: deja de desperdiciar crawls en URLs de bajo valor

Publicar a gran escala no es solo crear buenas páginas. También se trata de facilitar que los crawlers dediquen tiempo a las páginas que importan.

El crawl budget se desperdicia cuando los bots siguen encontrando muchas versiones de lo mismo, o muchas páginas que ofrecen poco valor. Los culpables típicos son parámetros de URL (ordenación, etiquetas de seguimiento), filtros facetados, archivos por etiquetas, vistas para imprimir y páginas que apenas difieren entre sí.

Señales de que estás perdiendo crawl budget:

- Muchas URLs que solo difieren por pequeños parámetros (como

?sort= o ?ref=)

- Filtros que crean combinaciones infinitas (color=, talla=, marca=)

- Páginas delgadas repetidas en muchas URLs

- Cadenas de redireccionamiento (varios saltos antes de la página final)

- Picos en errores 404/500 o timeouts en los logs del servidor

La velocidad y los errores afectan directamente la frecuencia de vuelta de los bots. Si tu sitio es lento o devuelve errores con frecuencia, los crawlers retroceden para no malgastar recursos. Arreglar errores 5xx, reducir timeouts y mejorar tiempos de respuesta puede aumentar la frecuencia de rastreo más que publicar aún más páginas.

Bloquear secciones de bajo valor puede ayudar, pero con cuidado. Bloquea áreas verdaderamente inútiles (combinaciones infinitas de filtros, resultados de búsqueda internos, páginas de calendario que generan URLs sin fin). No bloquees páginas que realmente quieras indexar solo porque son nuevas. Si una página debe posicionarse después, igual necesita ser rastreable ahora.

Reduce duplicados sin cambiar tu CMS

Aunque no puedas cambiar fácilmente la generación de URLs, puedes reducir señales duplicadas:

- Añade etiquetas canonical para que las versiones con parámetros apunten a la URL principal.

- Usa enlaces internos consistentes que siempre apunten a la URL limpia.

- Elimina URLs parametrizadas de tu sitemap XML.

- Añade reglas en robots.txt para patrones de basura obvios (solo cuando estés seguro).

- Normaliza redirecciones para que las variantes antiguas resuelvan en un solo salto.

Ejemplo: una página de categoría de ecommerce podría existir como /shoes, además de /shoes?sort=price y /shoes?color=black. Mantén /shoes indexable y enlazada internamente. Canonicaliza las variaciones hacia /shoes y mantén las variaciones fuera del sitemap. Eso empuja a los crawlers hacia la página correcta y fuera de bucles.

Enlaces internos que ayudan a que las páginas nuevas se descubran

Cuando publicas mucho, los enlaces internos son tu señal de descubrimiento más rápida. Los motores sólo pueden rastrear lo que pueden encontrar. Si las nuevas URLs no están enlazadas desde páginas que ya se rastrean, a menudo permanecen sin ser detectadas incluso si tu sitemap es perfecto.

Construye clusters que saquen a la luz las páginas nuevas

Piensa en clusters temáticos: una página central fuerte que se mantenga relevante (una guía, página de categoría, término de glosario o FAQ), más artículos de apoyo que respondan preguntas específicas. Cuando añades un artículo de apoyo nuevo, enlázalo desde la página central y desde 1-2 artículos de apoyo relacionados. Luego enlázalo de vuelta a la página central.

Ejemplo: una página central como "Fundamentos del email marketing" puede enlazar piezas nuevas como "Ejemplos de emails de bienvenida" y "Cómo limpiar tu lista". Esas páginas nuevas enlazan de vuelta al central, así los crawlers siguen moviéndose por el cluster en lugar de detenerse.

Usa un hub de contenido nuevo simple

Un hub de “contenido nuevo” ayuda cuando publicas a diario u horariamente. No necesita ser lujoso. Solo necesita ser fácil de alcanzar desde la navegación o la página principal y actualizarse automáticamente.

Mantenlo ordenado: muestra publicaciones recientes por tema y evita páginas de desplazamiento infinito que crecen sin control. Un hub así se convierte en un lugar fiable que los crawlers revisitan.

El texto de anclaje importa, pero de forma práctica. Usa palabras claras que describan la página ("lista de verificación de emails de bienvenida"), no etiquetas vagas ("haz clic aquí") ni stuffing de palabras clave.

Para la primera semana tras publicar, una regla simple funciona bien:

- Enlaza cada página nueva desde al menos 2 páginas ya rastreadas (un hub o página de categoría cuenta como una).

- Añade 1 enlace contextual desde un artículo antiguo estrechamente relacionado.

- Enlaza de vuelta a la página central del tema para mantener el cluster conectado.

- Mantén el número de enlaces razonable para que los enlaces importantes destaquen.

Vigila las páginas huérfanas (páginas sin enlaces internos que apunten a ellas). Una manera práctica de detectarlas es comparar la lista de URLs publicadas (o las URLs del sitemap) con lo que un rastreo del sitio reporta como "enlazadas internamente". Cualquier URL sin enlaces internos es un riesgo de descubrimiento.

Si tu sistema de publicación lo permite, integra enlaces internos en el paso de publicación para que las nuevas páginas no queden solas el día uno.

Sitemaps que se mantienen precisos a escala

A gran volumen, tu sitemap XML deja de ser un "nice to have" y se convierte en un panel de control. Indica a los motores qué cambió y qué importa.

Qué incluir (y qué mantener fuera)

Tu sitemap debería listar solo URLs que realmente quieras indexar y que un crawler pueda cargar con éxito.

Incluye páginas que:

- Sean indexables (no bloqueadas por robots, no marcadas

noindex)

- Sean canónicas a sí mismas (o tengas la certeza de que la URL listada es la canónica)

- Devuelvan 200 y rendericen contenido real

Mantén fuera filtros facetados, resultados de búsqueda internos, URLs parametrizadas infinitas, duplicados y páginas delgadas que no querrías que rankearan. Si una URL es un callejón sin salida para usuarios, normalmente también lo es para el rastreo.

Con qué frecuencia actualizar cuando publicas con frecuencia

Si publicas a diario u horariamente, trata tu sitemap como un feed vivo. Actualízalo cuando las páginas nuevas estén en vivo y elimina URLs que ya no existan o que no sean indexables. Esperar una semana puede dejar a los motores rastreando inventario antiguo mientras se pierden tus páginas más nuevas.

Usa el campo lastmod solo cuando puedas establecerlo con honestidad. Debe reflejar cambios de contenido significativos, no cada edición menor o reguardado. Inflar las fechas lastmod hace que los crawlers dejen de confiar en él.

Manejo de sitios grandes: múltiples sitemaps e índice de sitemaps

A medida que tu sitio crece, divide sitemaps por tipo (posts de blog, glosario, noticias) o por tiempo (por mes). Los sitemaps más pequeños se actualizan más rápido y los problemas son más fáciles de detectar.

Un índice de sitemaps actúa como un directorio que apunta a cada archivo sitemap. También ayuda a que los equipos asignen propiedad, de modo que una persona mantenga limpio el sitemap del blog mientras otra se ocupa de producto o URLs del glosario.

Chequeos de higiene del sitemap que detectan problemas temprano

Realiza estos chequeos regularmente, especialmente después de grandes lanzamientos:

- Las URLs devuelven 200 (no 3xx, 4xx o 5xx)

- Las URLs listadas coinciden con la URL canonical de la página

- Páginas con

noindex no están incluidas

lastmod cambia solo cuando el contenido realmente cambia- El sitemap no crece con URLs duplicadas o parametrizadas

Si generas páginas mediante una API o un CMS, automatiza estos chequeos para que los errores no crezcan con tu producción.

Chequeos de canonical, noindex y robots antes de publicar

A escala, pequeños errores técnicos se multiplican rápido. Un ajuste incorrecto en una plantilla puede ocultar cientos de páginas de búsqueda o inundar a los crawlers con duplicados.

Elige una versión preferida de la URL

Los motores quieren una versión principal de cada página. Decide tu formato preferido y úsalo en todas partes: HTTPS vs HTTP, www vs sin www, y barra final vs sin barra final.

Si tu sitio es accesible de varias formas (por ejemplo, con y sin barra final), creas copias que se leen igual. Eso hace el descubrimiento más lento y la indexación menos predecible.

Controles de canonical e indexación: qué verificar

Las etiquetas canonical indican a los motores: "Esta página es una copia, indexa la otra." Ayudan con near-duplicates (páginas para imprimir, vistas filtradas, páginas de ubicación muy similares), pero pueden ser peligrosas si se aplican de forma amplia.

Un patrón fallido común: una nueva plantilla de blog se despliega y accidentalmente pone el canonical apuntando a la página principal del blog para cada post. Los crawlers siguen recuperando las páginas, pero la indexación se detiene porque cada página afirma que no es la versión principal.

Antes de publicar un lote, revisa algunas URLs nuevas:

- El canonical apunta a sí mismo en páginas normales (no a una categoría o al homepage).

- La página es indexable (meta

noindex desactivado y no hay X-Robots-Tag: noindex).

- robots.txt permite el rastreo de las rutas usadas por las nuevas páginas.

- Las redirecciones aterrizan en un solo paso (evita cadenas).

- La URL final coincide con tu versión preferida (mismo host, protocolo y estilo de barra).

También observa las páginas “ruidosas”. Etiquetas, categorías y páginas paginadas pueden ser útiles para usuarios, pero pueden crear URLs de bajo valor sin fin si tu sistema genera muchas combinaciones. Ese ruido compite con contenido nuevo por atención.

Una regla práctica: mantén las páginas hub importantes rastreables, pero evita que variantes delgadas o repetitivas se multipliquen.

Paso a paso: un flujo de publicación e indexación escalable

Trata cada lote como un pequeño release. El objetivo es publicar páginas que sean fáciles de rastrear, fáciles de entender y conectadas inmediatamente con el resto de tu sitio.

1) Prepara el lote (antes de pulsar publicar)

Realiza chequeos rápidos en plantillas y contenido para no crear 200 problemas nuevos a la vez:

- Confirma que cada página devuelve 200 OK (sin 404s accidentales, redirecciones o renderizado bloqueado).

- Verifica que título, meta descripción y un encabezado principal claro (H1) estén presentes y no duplicados en el lote.

- Comprueba que las etiquetas canonical apunten a la URL preferida correcta.

- Añade datos estructurados solo si son precisos (por ejemplo, Article para posts de blog).

- Asegúrate de que las páginas sean indexables (noindex apagado, reglas robots permiten el rastreo).

Si puedes, escalona los lanzamientos. Publicar 50 páginas por día durante 4 días es más fácil de monitorizar que soltar 200 en una hora, y te ayuda a detectar errores de plantilla temprano.

2) Publica y luego haz que las páginas sean descubiertas (en minutos)

Publicar no es la línea de meta. Las nuevas URLs necesitan rutas claras desde páginas ya conocidas.

Después de que el lote esté en vivo, céntrate en tres acciones: añade enlaces internos desde hubs relevantes, actualiza tu sitemap XML y envía un ping de indexación responsable (por ejemplo, IndexNow) solo para las URLs nuevas.

3) Monitorea las primeras 48 horas (y qué hacer si nada aparece)

Dale tiempo a los motores, pero no esperes sin actuar. En el primer día o dos, muestrea 10 URLs y verifica que sean accesibles, estén enlazadas internamente y estén incluidas en el sitemap.

Si todavía no aparecen después de 48 horas, prioriza arreglos que desbloqueen el descubrimiento:

- Añade enlaces internos más fuertes (desde páginas de alto tráfico, páginas de categoría y posts recientes).

- Elimina trampas de rastreo (filtros infinitos, páginas de etiquetas duplicadas, resultados de búsqueda internos).

- Revisa de nuevo canonicals y

noindex (una configuración errónea puede ocultar toda una plantilla).

- Confirma que el sitemap contiene las nuevas URLs y que

lastmod se comporta correctamente.

- Reenvía un ping de indexación solo para las URLs que cambiaste o añadiste.

Ejemplo: si publicas 120 páginas de glosario, publica (o actualiza) también 3-5 hubs que las enlacen. Los hubs suelen rastrearse primero y arrastran las páginas nuevas con ellos.

Pings de indexación proactivos (incluido IndexNow) hechos responsablemente

Los pings de indexación son un empujón útil, no un interruptor mágico. Ayudan más cuando publicas muchas páginas y quieres que los motores noten los cambios rápido, especialmente para actualizaciones sensibles al tiempo (cambios de precio, páginas fuera de stock, noticias de última hora) o cuando eliminas URLs y quieres que desaparezcan antes.

No sirven si la página está bloqueada por robots.txt, marcada con noindex, sin enlaces internos o devuelve errores. En esos casos, los pings solo envían crawlers a un callejón sin salida.

Qué hace IndexNow (en términos simples)

IndexNow es un mensaje simple de "esta URL cambió" que envías a motores participantes. En lugar de esperar a que los crawlers redescubran cambios, proporcionas una lista de URLs que son nuevas, actualizadas o eliminadas. Los motores pueden entonces elegir rastrearlas antes. La indexación sigue siendo su decisión, pero el descubrimiento suele acelerarse.

Ejemplo: actualizas 200 posts antiguos con nuevas secciones. Sin pings, los crawlers podrían tardar días o semanas en revisarlos todos. Con IndexNow, puedes señalarles las URLs exactas que cambiaron.

Mantén los lotes de pings ligados a cambios reales:

- URLs recién publicadas que devuelven 200 y están enlazadas internamente

- URLs actualizadas donde el contenido cambió de forma significativa

- URLs eliminadas (404/410) o redirigidas (301) después de que el cambio esté en vivo

- Solo URLs canónicas (evita variantes, parámetros y URLs de seguimiento)

El ruido es la forma más rápida de volver inútiles los pings. Evita re-pinear la misma URL cada hora, enviar URLs antes de que sean accesibles o bombardear grandes listas cuando solo cambiaron unas pocas páginas.

Errores comunes que causan retrasos de indexación a escala

Los retrasos de indexación a menudo no son culpa del motor de búsqueda. Suelen ser autoinfligidos. La meta es simple: facilita a los crawlers encontrar tus mejores URLs y dificulta que pierdan tiempo en todo lo demás.

Una trampa común es producir masivamente páginas que te parecen diferentes, pero que para un crawler no lo son. Si cientos de páginas sólo cambian un nombre de ciudad, un adjetivo de producto o unas pocas frases, pueden ser tratadas como near-duplicates. Los crawlers pueden ralentizarse, indexar menos páginas o elegir una versión distinta de la que tú quieres.

Otro asesino del crawl budget es el crecimiento descontrolado de URLs. Filtros facetados, búsqueda interna, páginas de etiquetas, archivos de calendario y parámetros de seguimiento pueden multiplicarse en miles de URLs rastreables. Aunque no sean dañinas, compiten por la atención con contenido nuevo.

Errores que aparecen con más frecuencia:

- Publicar grandes lotes de páginas muy similares sin valor único.

- Permitir que etiquetas, filtros, búsqueda interna y parámetros generen variaciones infinitas de URLs.

- Confiar solo en el sitemap sin enlaces internos fuertes desde hubs relevantes.

- Incluir en sitemaps URLs que redirigen, no canónicas, bloqueadas o con

noindex.

- Renombrar o mover URLs repetidamente justo después del lanzamiento, creando re-rastreo, redirecciones y señales duplicadas.

Ejemplo: un blog inmobiliario publica 500 guías de vecindarios en una semana. Si cada guía es básicamente una plantilla con frases intercambiadas, y el sitio además expone filtros infinitos (habitaciones, baños, precio, orden), los crawlers pueden quedarse atrapados explorando filtros mientras las guías permanecen sin descubrir.

Arreglar esto suele ser menos cuestión de hacer más y más de afinar las señales: enlaza nuevas páginas desde unas pocas páginas de categoría muy transitadas, mantén sitemaps limpios y congela URLs hasta que las páginas hayan sido rastreadas y asentadas.

Una lista de verificación rápida y siguientes pasos

Pequeños problemas se acumulan rápido a alto volumen. Estos chequeos ayudan a que las nuevas URLs no queden atascadas.

Lista de verificación rápida para publicar (por página)

- Alcanzable y rápida: devuelve 200, no hay cadenas de redirección, sin errores de servidor.

- Indexable: sin

noindex accidental, sin reglas de robots que lo bloqueen, no detrás de un login.

- Canonical limpio: apunta a la URL final correcta (no staging, no una URL con parámetros).

- Descubrible: al menos un enlace interno relevante desde una página indexada.

- Incluida en tu sitemap: aparece en el sitemap XML correcto, con

lastmod correcto y sin duplicados.

Si falla una, arréglala antes de publicar más. Si no, crearás un backlog donde los crawlers siguen revisitando las URLs equivocadas.

Rutina semanal simple (15-30 minutos)

Escoge un día a la semana para una limpieza ligera:

- Muestra algunas URLs nuevas y confirma que se rastrean y indexan.

- Elimina de sitemaps las URLs que redirigen, son canónicas a otra, están en

noindex o devuelven error.

- Vigila picos en errores 5xx, tiempos de respuesta lentos y crecimiento de redirecciones.

- Poda páginas de etiquetas delgadas, duplicados y páginas de parámetros que no merecen rastreo.

Si tu equipo copia URLs en hojas de cálculo, edita sitemaps manualmente y envía solicitudes de indexación a mano, la automatización suele ser el punto de inflexión. Algunos equipos usan un sistema como GENERATED (generated.app) para generar y pulir contenido, mantener los sitemaps al día y enviar pings IndexNow como parte de un flujo de publicación impulsado por API, de modo que el proceso se mantenga consistente a medida que crece la producción.