Como se manifestam os atrasos de indexação quando você publica muito

Atrasos de indexação normalmente seguem o mesmo padrão: você publica, a página fica no ar, mas não aparece nas buscas por dias (às vezes semanas). Em volumes baixos, esse atraso é fácil de não notar. Quando você publica dezenas de URLs por dia, o acúmulo fica óbvio porque novas páginas se empilham mais rápido do que entram no índice.

Um sinal comum é um status no Search Console como "Crawled, currently not indexed." Isso significa que um bot visitou a URL, mas não a armazenou como resultado pesquisável. Outro padrão: apenas uma fatia das suas páginas mais novas é indexada, enquanto áreas antigas do site continuam performando normalmente.

Quando você passa de 10 páginas para 1.000+, os crawlers precisam escolher onde gastar tempo. Se seu site produz muitas URLs similares (duplicadas, páginas rasas, variantes por parâmetros), os bots podem desperdiçar visitas nas coisas erradas. As páginas que você realmente quer acabam esperando.

Problemas de "crawled but not indexed" em alto volume geralmente se resumem a algumas causas:

- A página parece muito semelhante a outras existentes (templates reaproveitados, introduções repetidas, tópicos quase-idênticos).

- A página parece sem importância (poucos links internos, enterrada em paginação).

- A página envia sinais técnicos mistos (canonical errado,

noindex acidental, recursos bloqueados).

- O site gera muitas URLs de baixo valor (filtros, parâmetros de rastreamento, navegação facetada).

- O conteúdo não satisfaz a intenção (rasa, desatualizada ou faltando detalhes-chave).

Uma forma rápida de distinguir problemas de qualidade de problemas de descoberta é amostrar um pequeno lote de URLs novas (por exemplo 20) e fazer duas perguntas.

Primeiro: um crawler consegue descobrir facilmente a página? Confirme que a URL está no seu sitemap XML, tem pelo menos um link interno proeminente, retorna 200 OK e não está bloqueada por regras de robots.

Segundo: se descoberta, ela vale a pena ser indexada? Procure por real unicidade (não ser uma reescrita de uma página existente), correspondência clara de intenção (responde a uma pergunta real) e substância suficiente (especificidades e exemplos, não apenas um template).

Se a maioria da sua amostra falhar na primeira pergunta, você tem um problema de sistema de descoberta. Se passarem na descoberta mas falharem na segunda, você tem um problema de qualidade e duplicação. Corrija o que for certo e o backlog geralmente encolhe rápido.

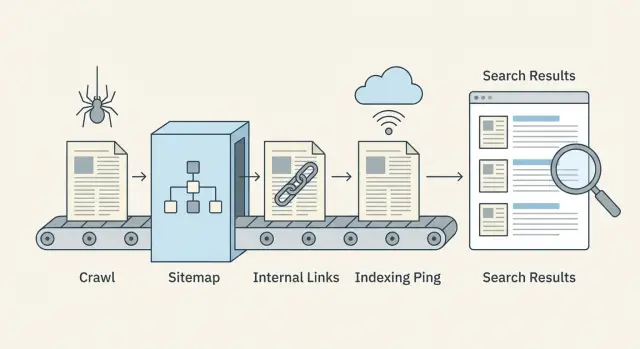

O fluxo crawl-para-index em linguagem simples

Publicar não torna uma página instantaneamente pesquisável. Os motores de busca a movem por um pipeline, e atrasos podem acontecer em qualquer etapa.

Descoberta, crawling e indexação (o que significam)

Descoberta é quando um motor de busca aprende que uma URL existe. Isso geralmente acontece por links internos, seu sitemap XML ou uma menção externa.

Crawling é quando um bot visita a URL e baixa o que vê (HTML, recursos principais e às vezes URLs linkadas adicionais). O crawling é limitado por tempo e atenção, então algumas páginas são visitadas tardiamente ou raramente.

Indexação é quando o motor decide se vai armazenar a página e mostrá-la nos resultados, e para quais consultas. Uma página rastreada não é garantia de ser indexada.

O fluxo fica assim:

- O motor encontra a URL (descoberta)

- O bot busca a página (crawl)

- A página é avaliada e ou armazenada ou pulada (index)

- Rankings são atualizados ao longo do tempo conforme sinais se acumulam

Onde os atrasos normalmente ocorrem

A maioria dos gargalos acontece antes do bot alcançar a página, ou logo depois que ele a rastreia.

Atrasos de descoberta aparecem quando novas páginas estão órfãs (sem links apontando para elas) ou quando sitemaps estão desatualizados.

Atrasos de crawling frequentemente vêm de gastar crawls em URLs de baixo valor (caminhos duplicados, páginas facetadas, spam de parâmetros) ou de respostas lentas do servidor.

Atrasos de indexação acontecem quando páginas parecem muito parecidas com outras, têm conteúdo raso, enviam sinais mistos (canonical apontando para outro lugar, noindex acidental) ou carregam conteúdo chave tarde.

Sinais que você pode mudar rápido vs devagar

Alavancas rápidas são principalmente técnicas e estruturais: links internos mais fortes vindos de páginas já rastreadas, sitemaps precisos, menos armadilhas de crawling, melhores tempos de resposta e pings proativos de indexação quando fazem sentido.

Alavancas mais lentas demoram a mostrar resultados: qualidade geral do site, consistência, links conquistados e sinais de engajamento de longo prazo.

O que medir semanalmente

Você não precisa de um dashboard complexo para detectar problemas cedo. Acompanhe um pequeno conjunto de números a cada semana:

- Novas URLs publicadas vs. novas URLs indexadas

- Tempo mediano do publish até o primeiro crawl

- Erros de crawl e respostas lentas (5xx, timeouts)

- Percentual de "Discovered, currently not indexed" e "Crawled, currently not indexed"

- Cobertura do sitemap: URLs no sitemap vs. URLs realmente indexáveis

Crawl budget: pare de desperdiçar crawls em URLs de baixo valor

Publicar em volume não é só criar boas páginas. É também facilitar para os crawlers gastarem tempo nas páginas que importam.

O crawl budget é desperdiçado quando os bots continuam encontrando muitas versões da mesma coisa, ou muitas páginas de pouco valor. Culpados típicos são parâmetros de URL (ordenar, tags de rastreamento), filtros facetados, arquivos de tags, visualizações de impressão e páginas que mal diferem umas das outras.

Sinais de que você está vazando crawl budget:

- Muitas URLs que diferem apenas por pequenos parâmetros (como

?sort= ou ?ref=)

- Filtros que criam combinações infinitas (color=, size=, brand=)

- Páginas rasas repetidas em muitas URLs

- Cadeias de redirecionamento (vários saltos antes da página final)

- Picos em erros 404/500 ou timeouts nos logs do servidor

Velocidade e erros afetam diretamente com que frequência os bots retornam. Se seu site é lento ou frequentemente retorna erros, os crawlers recuam para evitar desperdício de recursos. Corrigir erros 5xx, reduzir timeouts e melhorar tempos de resposta pode aumentar a frequência de crawl mais do que publicar ainda mais páginas.

Bloquear seções de baixo valor pode ajudar, mas faça com cuidado. Bloqueie áreas realmente inúteis (combinações infinitas de filtros, resultados de busca interna, páginas de calendário que geram URLs sem fim). Não bloqueie páginas que você quer indexar só porque são novas. Se uma página deve rankear depois, ainda precisa ser rastreável agora.

Reduza duplicatas sem mudar seu CMS

Mesmo que você não possa mudar facilmente a geração de URLs, você pode reduzir sinais de duplicação:

- Adicione tags canonical para que versões com parâmetros apontem para a URL principal.

- Use links internos consistentes que sempre apontem para a URL limpa.

- Remova URLs parametrizadas do seu sitemap XML.

- Adicione regras no robots.txt para padrões óbvios de lixo (somente quando tiver certeza).

- Normalize redirecionamentos para que variantes antigas resolvam em um salto.

Exemplo: uma página de categoria de comércio eletrônico pode existir como /shoes, além de /shoes?sort=price e /shoes?color=black. Mantenha /shoes indexável e linkado internamente. Canonicalize as variações de volta para /shoes e mantenha as variações fora do sitemap. Isso direciona crawlers para a página certa e os afasta de loops.

Links internos que ajudam páginas novas a serem descobertas

Quando você publica muito, links internos são seu sinal de descoberta mais rápido. Motores de busca só conseguem rastrear o que conseguem encontrar. Se novas URLs não estão linkadas a partir de páginas que já são rastreadas, elas frequentemente ficam sem atenção mesmo que seu sitemap seja perfeito.

Construa clusters que naturalmente surfacem novas páginas

Pense em clusters de tópicos: uma página central forte que se mantém relevante (um guia, página de categoria, termo de glossário ou FAQ), mais artigos de apoio que respondem perguntas específicas. Quando você adiciona um novo artigo de apoio, linke-o a partir da página central e de 1-2 artigos de apoio relacionados. Depois linke-o de volta para a página central.

Exemplo: uma página central como "Email marketing basics" pode linkar para peças novas como "Welcome email examples" e "How to clean your list." Essas páginas novas linkam de volta para a central, assim os crawlers continuam se movendo pelo cluster em vez de parar.

Use um hub simples de conteúdo novo

Uma página hub de "Novo conteúdo" ajuda quando você publica diariamente ou a cada hora. Não precisa ser sofisticada. Só precisa ser fácil de alcançar a partir da navegação ou homepage e atualizada automaticamente.

Mantenha-a organizada: mostre posts recentes por tópico e evite páginas de rolagem infinita que crescem para sempre. Um hub assim se torna um lugar confiável que os crawlers revisitam.

O texto âncora importa, mas apenas de forma prática. Use palavras claras que descrevam a página (welcome email checklist), não rótulos vagos ("clique aqui") e não stuffing de palavras-chave.

Para a primeira semana após a publicação, um conjunto simples de regras funciona bem:

- Linke cada nova página a partir de pelo menos 2 páginas já rastreadas (um hub ou página de categoria conta como uma).

- Adicione 1 link contextual a partir de um artigo mais antigo e estreitamente relacionado.

- Linke de volta para a página de tópico principal para manter o cluster conectado.

- Mantenha a contagem de links razoável para que links importantes se destaquem.

Fique de olho em páginas órfãs (páginas sem links internos apontando para elas). Uma maneira prática de identificá-las é comparar sua lista de URLs publicadas (ou URLs do sitemap) com o que um rastreio do site relata como "internally linked." Qualquer URL sem links internos é um risco de descoberta.

Se seu sistema de publicação suportar, incorpore links internos na etapa de publicação para que novas páginas não fiquem sozinhas no primeiro dia.

Sitemaps que permanecem precisos em escala

Em volume, seu sitemap XML deixa de ser um "bom ter" e vira um painel de controle. Ele diz aos buscadores o que mudou e o que importa.

O que incluir (e o que manter de fora)

Seu sitemap deve listar apenas URLs que você realmente quer indexar e que um crawler consiga carregar com sucesso.

Inclua páginas que são:

- Indexáveis (não bloqueadas por robots, não marcadas com

noindex)

- Canonical para si mesmas (ou você tem certeza de que a URL listada é a canônica)

- Retornando 200 e renderizando conteúdo real

Mantenha fora filtros facetados, resultados de busca interna, URLs paramétricas infinitas, duplicatas e páginas rasas que você não quer que ranqueiem. Se uma URL é um beco sem saída para usuários, geralmente é um beco sem saída para crawl também.

Se você publica diariamente ou por hora, trate seu sitemap como um feed vivo. Atualize-o assim que novas páginas entrarem no ar e remova URLs que se foram ou que não são mais indexáveis. Esperar uma semana pode deixar os motores rastreando inventário antigo enquanto perdem suas páginas mais novas.

Use o campo lastmod apenas quando puder defini-lo honestamente. Deve refletir mudanças significativas de conteúdo, não cada edição menor ou re-salvamento. Datas lastmod infladas ensinam os crawlers a parar de confiar nelas.

À medida que seu site cresce, divida sitemaps por tipo (posts do blog, glossário, notícias) ou por tempo (por mês). Sitemaps menores atualizam mais rápido e problemas são mais fáceis de detectar.

Um índice de sitemaps atua como um diretório que aponta para cada arquivo de sitemap. Também ajuda times a atribuir propriedade, então uma pessoa pode manter o sitemap do blog limpo enquanto outra cuida de URLs de produto ou glossário.

Checagens de higiene do sitemap que pegam problemas cedo

Execute estas verificações regularmente, especialmente após grandes lançamentos:

- URLs retornam 200 (não 3xx, 4xx ou 5xx)

- URLs listadas correspondem ao canonical da página

- Páginas

noindex não estão incluídas

lastmod muda apenas quando o conteúdo realmente muda- O sitemap não está crescendo com duplicatas ou URLs com parâmetros

Se você gera páginas via API ou CMS, automatize essas checagens para que erros não cresçam junto com sua produção.

Canonical, noindex e checagens de robots antes de publicar

Em volume, pequenos deslizes técnicos se multiplicam rápido. Uma configuração errada num template pode esconder centenas de páginas dos buscadores ou inundar crawlers com duplicatas.

Escolha uma versão preferida de URL

Os buscadores querem uma versão principal de cada página. Decida seu formato preferido e mantenha-o em todos os lugares: HTTPS vs HTTP, www vs non-www, e barra final vs sem barra.

Se seu site for acessível de múltiplas formas (por exemplo, com e sem barra final), você cria cópias que leem o mesmo conteúdo. Isso torna a descoberta mais lenta e a indexação menos previsível.

Controles de canonical e indexação: o que verificar

Tags canonical dizem aos buscadores: "Esta página é uma cópia, indexe aquela outra." Elas ajudam com quase-duplicatas (páginas de impressão, views filtradas, páginas de localização muito semelhantes), mas podem ser perigosas se aplicadas de forma ampla.

Um padrão comum de falha: um novo template de blog é lançado e acidentalmente define o canonical para a homepage do blog em cada post. Crawlers ainda buscam as páginas, mas a indexação estagna porque cada página afirma que não é a versão principal.

Antes de publicar um lote, verifique algumas URLs novas:

- O canonical aponta para si mesmo em páginas normais (não para uma categoria ou para a homepage).

- A página é indexável (meta

noindex desligada e sem X-Robots-Tag: noindex).

- robots.txt permite o crawling dos caminhos usados pelas novas páginas.

- Redirecionamentos aterrissam em um passo (evite cadeias).

- A URL final corresponde à sua versão preferida (mesmo host, protocolo e estilo de barra).

Também observe páginas "ruído". Páginas de tag, categoria e paginadas podem ser úteis para usuários, mas podem criar URLs de baixo valor sem fim se seu sistema gerar muitas combinações. Esse ruído compete com conteúdo novo pela atenção.

Uma regra prática: mantenha páginas hub importantes rastreáveis, mas evite que variantes rasas ou repetitivas se multipliquem.

Passo a passo: um fluxo escalável de publicação e indexação

Trate cada lote como um pequeno release. O objetivo é publicar páginas que sejam fáceis de rastrear, fáceis de entender e imediatamente conectadas ao resto do seu site.

1) Prepare o lote (antes de publicar)

Faça checagens rápidas em templates e conteúdo para não criar 200 novos problemas de uma vez:

- Confirme que cada página retorna 200 OK (sem 404s acidentais, redirecionamentos ou renderização bloqueada).

- Verifique título, meta description e um cabeçalho principal claro (H1) presentes e não duplicados no lote.

- Confirme que as tags canonical apontam para a URL preferida correta.

- Adicione structured data somente se for preciso (por exemplo, Article para posts de blog).

- Garanta que as páginas sejam indexáveis (

noindex desligado, regras de robots permitam crawling).

Se puder, escalone os lançamentos. Publicar 50 páginas por dia durante 4 dias é mais fácil de monitorar do que soltar 200 em uma hora, e ajuda a detectar erros de template cedo.

2) Publique, depois torne as páginas descobertas (em minutos)

Publicar não é a linha de chegada. Novas URLs precisam de caminhos claros a partir de páginas conhecidas.

Após o lote entrar no ar, foque em três ações: adicione links internos a partir de hubs relevantes, atualize seu sitemap XML e envie um ping de indexação responsável (por exemplo, IndexNow) apenas para as URLs novas.

3) Monitore as primeiras 48 horas (e o que fazer se nada aparecer)

Dê tempo aos buscadores, mas não espere cegamente. Nas primeiras 24–48 horas, amostre 10 URLs e verifique se estão alcançáveis, linkadas internamente e incluídas no sitemap.

Se ainda não aparecerem depois de 48 horas, priorize correções que liberem a descoberta:

- Adicione links internos mais fortes (de páginas de alto tráfego, páginas de categoria e posts recentes).

- Remova armadilhas de crawling (filtros infinitos, páginas de tag duplicadas, resultados de busca interna).

- Recheque canonicals e

noindex (uma configuração errada pode esconder um template inteiro).

- Confirme que o sitemap contém as URLs novas e que

lastmod se comporta corretamente.

- Reenvie um ping de indexação apenas para URLs que você mudou ou adicionou.

Exemplo: se você publicar 120 páginas de glossário, também publique (ou atualize) 3–5 hubs que linkem para elas. Hubs frequentemente são rastreados primeiro e puxam as páginas novas com elas.

Pings de indexação são um empurrão útil, não um interruptor mágico. Ajudam mais quando você publica muitas páginas e quer que os buscadores notem mudanças rapidamente, especialmente para atualizações sensíveis ao tempo (mudanças de preço, fora de estoque, notícias de última hora) ou quando você remove URLs e quer que elas desapareçam mais cedo.

Eles não ajudam se a página estiver bloqueada por robots.txt, marcada noindex, sem links internos ou retornando erros. Nesses casos, pings só mandam crawlers para um beco sem saída.

O que o IndexNow faz (em termos simples)

IndexNow é uma mensagem simples de "esta URL mudou" que você envia para motores participantes. Em vez de esperar que os crawlers redescubram mudanças, você fornece uma lista de URLs novas, atualizadas ou removidas. Os buscadores podem então escolher rastrear essas URLs mais cedo. A indexação continua sendo decisão deles, mas a descoberta geralmente é mais rápida.

Exemplo: você atualiza 200 posts antigos com novas seções. Sem pings, os crawlers podem levar dias ou semanas para revisitá-los todos. Com IndexNow, você aponta exatamente as URLs que mudaram.

Mantenha lotes de ping ligados a mudanças reais:

- URLs recém-publicadas que retornam 200 e estão linkadas internamente

- URLs atualizadas onde o conteúdo mudou de forma significativa

- URLs removidas (404/410) ou URLs redirecionadas (301) depois da mudança estar no ar

- URLs canônicas somente (evite variantes, parâmetros e URLs de rastreamento)

Ruído é a maneira mais rápida de tornar pings inúteis. Evite reenviar o mesmo URL a cada hora, enviar URLs antes de estarem acessíveis ou explodir listas enormes quando só algumas páginas mudaram.

Erros comuns que causam atrasos de indexação em escala

Atrasos de indexação muitas vezes não são problema do buscador. Geralmente são autoinfligidos. O objetivo é simples: torne fácil para os crawlers encontrar suas melhores URLs e difícil gastar tempo com todo o resto.

Uma armadilha comum é produzir em massa páginas que parecem diferentes para você, mas não para um crawler. Se centenas de páginas apenas trocam o nome de uma cidade, um adjetivo de produto ou algumas frases, elas podem ser tratadas como quase-duplicatas. Crawlers podem desacelerar, indexar menos páginas ou escolher uma versão diferente da que você quer.

Outro matador de crawl-budget é o crescimento descontrolado de URLs. Filtros facetados, busca interna, páginas de tag, arquivos de calendário e parâmetros de rastreamento podem se multiplicar em milhares de URLs rastreáveis. Mesmo que não sejam danosos, competem pela atenção com conteúdo novo.

Erros que aparecem com mais frequência:

- Publicar grandes lotes de páginas muito semelhantes sem valor único

- Deixar tags, filtros, busca interna e parâmetros gerarem variações infinitas de URL

- Confiar apenas no sitemap, sem links internos fortes a partir de hubs relevantes

- Incluir sitemaps URLs que redirecionam, não são canônicas, estão bloqueadas ou têm

noindex

- Renomear ou mover URLs repetidamente logo após o lançamento, criando recrawls, redirecionamentos e sinais de duplicação

Exemplo: um blog imobiliário publica 500 guias de bairro em uma semana. Se cada guia for basicamente um template com frases trocadas, e o site também expõe filtros infinitos (quartos, banheiros, preço, ordenação), os crawlers podem ficar presos explorando filtros enquanto os guias ficam sem descoberta.

Corrigir isso normalmente é menos sobre criar cada vez mais e mais sobre apertar sinais: linke páginas novas a partir de algumas páginas de categoria bem visitadas, mantenha sitemaps limpos e congele URLs até que as páginas tenham tempo de ser rastreadas e estabilizarem.

Um checklist rápido e próximos passos

Pequenos problemas se acumulam rápido em alto volume. Essas checagens ajudam a evitar que novas URLs fiquem presas.

Checklist rápido de publicação (por página)

- Alcançável e rápido: retorna 200, sem cadeias de redirecionamento, sem erros de servidor.

- Indexável: sem

noindex acidental, sem regras de robots bloqueando, não atrás de login.

- Canonical limpo: aponta para a URL final correta (não staging, não uma URL com parâmetros).

- Descobrável: pelo menos um link interno relevante a partir de uma página indexada.

- Incluída no seu sitemap: aparece no sitemap XML certo, com

lastmod correto e sem duplicatas.

Se algum falhar, corrija antes de publicar mais. Caso contrário você cria um backlog onde os crawlers continuam visitando as URLs erradas.

Uma rotina semanal simples (15–30 minutos)

Escolha um dia por semana para uma limpeza leve:

- Amostre algumas URLs novas e confirme que são rastreadas e indexadas.

- Remova do sitemap URLs que redirecionam, são canonicalizadas,

noindex ou com erro.

- Observe picos em erros 5xx, tempos de resposta lentos e crescimento de redirecionamentos.

- Apare as páginas de tag rasas, duplicatas e páginas com parâmetros que não merecem crawling.

Se sua equipe está copiando URLs em planilhas, editando sitemaps manualmente e enviando pedidos de indexação na mão, a automação costuma ser o ponto de virada. Alguns times usam um sistema como GENERATED (generated.app) para gerar e polir conteúdo, manter sitemaps atualizados e enviar pings IndexNow como parte de um fluxo de publicação por API, assim o processo permanece consistente conforme a produção cresce.