À quoi ressemblent les délais d'indexation quand vous publiez beaucoup

Les délais d'indexation suivent généralement le même schéma : vous publiez, la page est en ligne, mais elle n'apparaît pas dans les résultats de recherche pendant des jours (parfois des semaines). À faible volume, ce retard passe inaperçu. Quand vous publiez des dizaines d'URL par jour, l'arriéré devient évident : les nouvelles pages s'accumulent plus vite qu'elles n'entrent dans l'index.

Un signe courant est un statut Search Console comme "Crawled, currently not indexed." Cela signifie qu'un bot a visité l'URL, mais ne l'a pas stockée comme résultat consultable. Un autre schéma : seule une partie de vos pages récentes est indexée, tandis que d'autres sections plus anciennes continuent de bien performer.

Quand vous passez de 10 pages à 1 000+, les crawlers doivent choisir où investir leur temps. Si votre site produit beaucoup d'URL similaires (dupliquées, pages fines, variantes avec paramètres), les bots peuvent gaspiller des visites sur les mauvaises cibles. Les pages qui vous importent finissent par attendre.

Les problèmes « crawled but not indexed » à fort volume tiennent généralement à quelques causes :

- La page ressemble trop à des pages existantes (templates réutilisés, introductions répétées, sujets presque identiques).

- La page paraît peu importante (peu de liens internes, enfouie dans la pagination).

- La page envoie des signaux techniques contradictoires (canonical erroné,

noindex accidentel, ressources bloquées).

- Le site génère trop d'URL à faible valeur (filtres, paramètres de suivi, navigation facettée).

- Le contenu ne satisfait pas la requête (trop maigre, obsolète, ou sans détails clés).

Une manière rapide de distinguer problèmes de qualité et problèmes de découverte est d'échantillonner un petit lot de nouvelles URL (par exemple 20) et de poser deux questions.

D'abord : un crawler peut-il facilement la découvrir ? Confirmez que l'URL est dans votre sitemap XML, qu'elle a au moins un lien interne visible, qu'elle renvoie 200 OK, et qu'elle n'est pas bloquée par les règles robots.

Ensuite : si elle est découverte, mérite-t-elle d'être indexée ? Cherchez une vraie originalité (pas une réécriture d'une page existante), une adéquation claire d'intention (elle répond à une vraie question) et suffisamment de substance (exemples et spécificités, pas juste un template).

Si la plupart de votre échantillon échoue à la première question, vous avez un problème de découverte. S'ils passent la découverte mais échouent à la qualité, vous avez un problème de duplication/qualité. Corrigez le bon angle et l'arriéré diminue généralement vite.

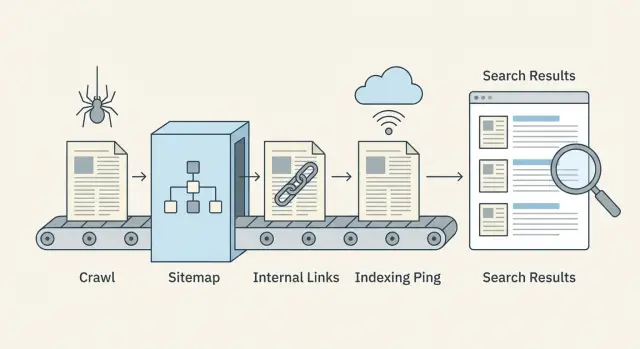

Le flux discovery → crawl → index en langage simple

Publier ne rend pas une page immédiatement consultable. Les moteurs de recherche la font passer par un pipeline, et des délais peuvent apparaître à chaque étape.

Découverte, crawl et indexation (ce que ça veut dire)

La découverte, c'est quand un moteur apprend qu'une URL existe. Cela arrive via des liens internes, votre sitemap XML ou une mention externe.

Le crawl, c'est quand un bot visite l'URL et télécharge ce qu'il voit (HTML, ressources clés, et parfois des URL liées supplémentaires). Le crawl est limité par le temps et l'attention, donc certaines pages sont visitées tard ou rarement.

L'indexation, c'est quand le moteur décide de stocker la page et pour quelles requêtes il peut l'afficher. Une page crawlee n'est pas forcément indexée.

Le flux ressemble à ceci :

- Le moteur trouve l'URL (découverte)

- Le bot récupère la page (crawl)

- La page est évaluée et soit stockée soit ignorée (index)

- Les classements évoluent avec le temps au fur et à mesure que les signaux s'accumulent

Où les délais surviennent le plus souvent

La plupart des lenteurs arrivent avant que le bot n'atteigne la page, ou juste après le crawl.

Les délais de découverte apparaissent quand les nouvelles pages sont orphelines (aucun lien pointant vers elles) ou quand les sitemaps sont obsolètes.

Les retards de crawl viennent souvent du gaspillage de crawls sur des URL à faible valeur (chemins dupliqués, pages facettées, spam de paramètres) ou de réponses serveur lentes.

Les délais d'indexation surviennent quand les pages ressemblent trop à d'autres, ont un contenu maigre, envoient des signaux mixtes (canonical pointant ailleurs, noindex accidentel), ou chargent le contenu-clé trop tard.

Signaux que vous pouvez changer vite vs lentement

Les leviers rapides sont majoritairement techniques et structurels : liens internes plus forts depuis des pages déjà crawlées, sitemaps précis, moins de pièges de crawl, meilleurs temps de réponse, et pings d'indexation proactifs quand ils sont pertinents.

Les leviers lents mettent du temps à produire des effets : qualité globale du site, cohérence, liens gagnés naturellement et signaux d'engagement à long terme.

Que mesurer chaque semaine

Vous n'avez pas besoin d'un tableau de bord complexe pour détecter les problèmes tôt. Suivez un petit nombre de métriques chaque semaine :

- Nouvelles URL publiées vs nouvelles URL indexées

- Temps médian entre publication et premier crawl

- Erreurs de crawl et réponses lentes (5xx, timeouts)

- Part des statuts « Discovered, currently not indexed » et « Crawled, currently not indexed »

- Couverture du sitemap : URLs dans le sitemap vs URLs réellement indexables

Crawl budget : cessez de gaspiller des crawls sur des URL de faible valeur

Publier en volume ne consiste pas seulement à créer de bonnes pages. Il faut aussi faciliter le travail des crawlers pour qu'ils consacrent du temps aux pages importantes.

Le crawl budget est gaspilléd quand les bots trouvent de nombreuses versions d'une même chose, ou beaucoup de pages peu utiles. Les coupables typiques sont les paramètres d'URL (tri, balises de suivi), la navigation facettée, les archives par tag, les vues d'impression, et les pages qui ne diffèrent guère les unes des autres.

Signes d'une fuite de crawl budget :

- Beaucoup d'URL ne différant que par de petits paramètres (comme

?sort= ou ?ref=)

- Des filtres qui créent des combinaisons infinies (color=, size=, brand=)

- Pages fines répétées sur de nombreuses URL

- Chaînes de redirection (plusieurs sauts avant d'arriver à la page finale)

- Pics de 404/500 ou de timeouts dans les logs serveur

La vitesse et les erreurs affectent directement la fréquence de retour des bots. Si votre site est lent ou renvoie souvent des erreurs, les crawlers réduisent la vitesse pour éviter de gaspiller des ressources. Corriger les erreurs 5xx, réduire les timeouts et améliorer les temps de réponse peut augmenter la fréquence de crawl plus efficacement que de publier encore plus de pages.

Bloquer des sections à faible valeur peut aider, mais faites-le prudemment. Bloquez les zones véritablement inutiles (combinaisons de filtres infinies, résultats de recherche internes, pages calendrier qui génèrent des URL sans fin). Ne bloquez pas des pages que vous voulez indexer juste parce qu'elles sont nouvelles. Si une page doit être classée plus tard, elle doit rester crawlable maintenant.

Réduire les duplications sans changer votre CMS

Même si vous ne pouvez pas facilement modifier la génération d'URL, vous pouvez réduire les signaux de duplication :

- Ajoutez des balises canonical pour que les versions paramétrées pointent vers l'URL principale.

- Utilisez des liens internes cohérents qui pointent toujours vers l'URL propre.

- Retirez les URL paramétrées de votre sitemap XML.

- Ajoutez des règles robots.txt pour les motifs de junk évidents (seulement quand vous en êtes certain).

- Normalisez les redirections pour que les variantes anciennes aboutissent en un seul saut.

Exemple : une page catégorie e-commerce peut exister comme /shoes, plus /shoes?sort=price et /shoes?color=black. Gardez /shoes indexable et lié en interne. Canonicalisez les variantes vers /shoes, et excluez-les du sitemap. Cela oriente les crawlers vers la bonne page et les éloigne des boucles.

Liens internes qui aident les nouvelles pages à être découvertes

Quand vous publiez beaucoup, les liens internes sont votre signal de découverte le plus rapide. Les moteurs ne peuvent crawler que ce qu'ils trouvent. Si les nouvelles URL ne sont pas liées depuis des pages déjà crawlées, elles restent souvent invisibles même si votre sitemap est parfait.

Construire des clusters qui font naturellement remonter les nouvelles pages

Pensez en clusters thématiques : une page cœur forte qui reste pertinente (un guide, une page catégorie, un terme de glossaire, ou une FAQ), plus des articles de soutien qui répondent à des questions spécifiques. Quand vous ajoutez un nouvel article de soutien, liez-le depuis la page cœur et depuis 1-2 articles de soutien connexes. Puis faites un lien retour vers le cœur.

Exemple : une page cœur comme « Email marketing basics » peut lier vers de nouvelles pages comme « Welcome email examples » et « How to clean your list. » Ces nouvelles pages renvoient vers la page cœur, de sorte que les crawlers continuent à traverser le cluster au lieu de s'arrêter.

Utiliser un simple hub de nouveau contenu

Un hub « New content » aide quand vous publiez quotidiennement ou à l'heure. Il n'a pas besoin d'être sophistiqué. Il doit juste être facile d'accès depuis la navigation ou la page d'accueil et mis à jour automatiquement.

Gardez-le propre : affichez les posts récents par sujet et évitez les pages à défilement infini qui grossissent sans fin. Un hub comme celui-ci devient un point fiable que les crawlers revisitent.

L'anchor text compte, mais de manière sensée. Utilisez des mots clairs qui décrivent la page ("welcome email checklist"), pas des libellés vagues ("cliquez ici"), et évitez le bourrage de mots-clés.

Pour la première semaine après publication, une règle simple fonctionne bien :

- Liez chaque nouvelle page depuis au moins 2 pages déjà crawlées (un hub ou une page catégorie compte pour une).

- Ajoutez 1 lien contextuel depuis un ancien article étroitement lié.

- Liez en retour vers la page cœur pour que le cluster reste connecté.

- Gardez le nombre de liens raisonnable pour que les liens importants ressortent.

Surveillez les pages orphelines (pages sans liens internes pointant vers elles). Une façon pratique de les repérer est de comparer votre liste d'URL publiées (ou les URLs du sitemap) avec ce qu'un crawl de site rapporte comme « lié en interne ». Toute URL sans liens internes est un risque de découverte.

Si votre système de publication le permet, intégrez des liens internes dans l'étape de publication pour que les nouvelles pages ne restent pas isolées le jour J.

Sitemaps qui restent précis à grande échelle

À volume, votre sitemap XML devient moins un "petit plus" et plus un panneau de contrôle. Il indique aux moteurs ce qui a changé et ce qui compte.

Ce qu'il faut inclure (et ce qu'il faut exclure)

Votre sitemap doit lister uniquement les URL que vous voulez réellement indexer et qu'un crawler peut charger avec succès.

Incluez les pages qui sont :

- indexables (non bloquées par robots, pas en

noindex)

- canoniques sur elles-mêmes (ou si vous êtes certain que l'URL listée est la canonique)

- renvoyant 200 et affichant du contenu réel

Ne mettez pas les filtres facettés, les résultats de recherche internes, les URL paramétrées, les doublons et les pages fines que vous ne voulez pas voir référencées. Si une URL est une impasse pour les utilisateurs, c'est généralement une impasse pour le crawling aussi.

À quelle fréquence mettre à jour quand on publie souvent

Si vous publiez quotidiennement ou toutes les heures, traitez votre sitemap comme un flux vivant. Mettez-le à jour au fur et à mesure que de nouvelles pages sont publiées et retirez les URL qui ont disparu ou ne sont plus indexables. Attendre une semaine peut laisser les moteurs crawler de l'inventaire ancien tout en manquant vos pages les plus récentes.

Utilisez le champ lastmod seulement si vous pouvez le renseigner honnêtement. Il doit refléter des changements de contenu significatifs, pas chaque édition mineure ou re-sauvegarde. Des lastmod gonflés font perdre confiance aux crawlers.

Gérer les grands sites : sitemaps multiples et index de sitemaps

À mesure que votre site grandit, divisez les sitemaps par type (articles de blog, glossaire, actualités) ou par période (par mois). Des sitemaps plus petits se mettent à jour plus vite et les problèmes sont plus faciles à repérer.

Un index de sitemaps sert de répertoire pointant vers chaque fichier sitemap. Il aide aussi à répartir la responsabilité entre les équipes : une personne peut garder propre le sitemap du blog pendant qu'une autre gère les URLs produit ou glossaire.

Contrôles d'hygiène du sitemap qui détectent les problèmes tôt

Exécutez ces vérifications régulièrement, surtout après des grosses publications :

- Les URLs renvoient 200 (pas 3xx, 4xx ou 5xx)

- Les URLs listées correspondent à la canonical de la page

- Les pages en

noindex ne sont pas incluses

lastmod change seulement quand le contenu change vraiment- Le sitemap ne grossit pas avec des doublons ou des URLs paramétrées

Si vous générez des pages via une API ou un CMS, automatisez ces contrôles pour que les erreurs ne croissent pas avec vous.

Vérifications canonical, noindex et robots avant publication

À volume, de petites fautes techniques se multiplient rapidement. Un mauvais réglage dans un template peut cacher des centaines de pages aux moteurs, ou inonder les crawlers de doublons.

Choisir une version d'URL préférée

Les moteurs veulent une version principale pour chaque page. Décidez d'un format préféré et appliquez-le partout : HTTPS vs HTTP, www vs non-www, et slash final vs pas de slash.

Si votre site est accessible de plusieurs manières (par exemple, avec et sans slash final), vous créez des copies qui se lisent de la même façon. Cela ralentit la découverte et rend l'indexation moins prévisible.

Contrôles des canonicals et du marquage d'indexation

Les balises canonical indiquent au moteur « cette page est une copie, indexez plutôt cette autre ». Elles aident pour les quasi-duplications (pages d'impression, vues filtrées, pages de localisation très similaires), mais peuvent être dangereuses si elles sont appliquées à tort.

Un schéma d'échec fréquent : un nouveau template de blog définit par accident la canonical vers la page d'accueil du blog pour chaque article. Les crawlers récupèrent toujours les pages, mais l'indexation stagne parce que chaque page affirme qu'elle n'est pas la version principale.

Avant de publier un lot, vérifiez un échantillon de nouvelles URL :

- Le canonical pointe vers elle-même sur les pages normales (pas vers une page catégorie ou la page d'accueil).

- La page est indexable (meta

noindex éteint et pas de X-Robots-Tag: noindex).

- robots.txt autorise le crawl des chemins utilisés par les nouvelles pages.

- Les redirections aboutissent en un seul saut (évitez les chaînes).

- L'URL finale correspond à votre version préférée (même hôte, protocole et style de slash).

Regardez aussi les pages « bruit ». Les pages de tag, catégorie et paginées peuvent être utiles aux utilisateurs, mais elles génèrent des URL à faible valeur si votre système produit beaucoup de combinaisons. Ce bruit concurrence les nouveaux contenus pour l'attention.

Une règle pratique : gardez les pages hub importantes crawlables, mais empêchez les variantes fines ou répétitives de se multiplier.

Étape par étape : un workflow scalable de publication et d'indexation

Traitez chaque lot comme une petite release. L'objectif est de livrer des pages faciles à crawler, faciles à comprendre et immédiatement connectées au reste de votre site.

1) Préparez le lot (avant de publier)

Faites des vérifications rapides sur les templates et le contenu pour ne pas créer 200 nouveaux problèmes en une fois :

- Confirmez que chaque page renvoie 200 OK (pas de 404 accidentels, redirections ou rendu bloqué).

- Vérifiez que titre, meta description et un titre principal clair (H1) sont présents et pas dupliqués dans le lot.

- Vérifiez que les balises canonical pointent vers l'URL préférée correcte.

- Ajoutez des données structurées uniquement si elles sont exactes (par exemple, Article pour les billets de blog).

- Assurez-vous que les pages sont indexables (pas de

noindex, règles robots autorisant le crawl).

Si possible, fractionnez les sorties. Publier 50 pages par jour sur 4 jours est plus simple à surveiller que lâcher 200 en une heure, et cela vous aide à détecter vite les erreurs de template.

2) Publiez, puis rendez les pages découvrables (en quelques minutes)

La publication n'est pas la ligne d'arrivée. Les nouvelles URL ont besoin de chemins clairs depuis des pages connues.

Après la mise en ligne du lot, concentrez-vous sur trois actions : ajoutez des liens internes depuis des pages hub pertinentes, mettez à jour votre sitemap XML, et envoyez un ping d'indexation responsable (par exemple IndexNow) uniquement pour les nouvelles URL.

3) Surveillez les premières 48 heures (et que faire si rien n'apparaît)

Laissez un peu de temps aux moteurs, mais n'attendez pas sans rien faire. Dans les 1–2 premiers jours, échantillonnez 10 URL et vérifiez qu'elles sont accessibles, liées en interne et incluses dans le sitemap.

Si elles n'apparaissent toujours pas après 48 heures, priorisez les corrections qui débloquent la découverte :

- Ajoutez des liens internes plus forts (depuis des pages à fort trafic, des pages catégorie et des posts récents).

- Supprimez les pièges de crawl (filtres infinis, pages de tag dupliquées, résultats de recherche internes).

- Revérifiez les canonicals et les

noindex (un mauvais réglage peut cacher tout un template).

- Confirmez que le sitemap contient les nouvelles URL et que

lastmod se comporte correctement.

- Renvoyez un ping d'indexation seulement pour les URL que vous avez modifiées ou ajoutées.

Exemple : si vous publiez 120 pages de glossaire, publiez (ou mettez à jour) aussi 3–5 pages hub qui y font référence. Les hubs sont souvent crawlés en premier et entraînent les nouvelles pages avec eux.

Pings d'indexation proactifs (y compris IndexNow) utilisés avec responsabilité

Les pings d'indexation sont un coup de pouce utile, pas un interrupteur magique. Ils aident surtout quand vous publiez beaucoup et voulez que les moteurs remarquent rapidement des changements, en particulier pour des mises à jour sensibles au temps (changement de prix, rupture de stock, actualités) ou quand vous supprimez des URL et souhaitez qu'elles disparaissent plus vite.

Ils n'aident pas si la page est bloquée par robots.txt, marquée noindex, sans liens internes, ou renvoie des erreurs. Dans ces cas, les pings envoient les crawlers vers une impasse.

Ce que fait IndexNow (en termes simples)

IndexNow est un message simple « cette URL a changé » que vous envoyez aux moteurs participants. Au lieu d'attendre que les crawlers redécouvrent les changements, vous fournissez une liste d'URL nouvelles, mises à jour ou supprimées. Les moteurs peuvent alors choisir de crawler ces URL plus tôt. L'indexation reste leur décision, mais la découverte est souvent plus rapide.

Exemple : vous mettez à jour 200 anciens articles avec de nouvelles sections. Sans pings, les crawlers peuvent prendre des jours ou des semaines pour tous les revisiter. Avec IndexNow, vous leur indiquez précisément quelles URL ont changé.

Gardez les lots de pings liés à des changements réels :

- URL nouvellement publiées qui renvoient 200 et sont liées en interne

- URL mises à jour dont le sens du contenu a changé

- URL supprimées (404/410) ou redirigées (301) après que le changement soit en ligne

- URL canoniques seulement (évitez les variantes, paramètres et URLs de suivi)

Le bruit est le moyen le plus rapide de rendre les pings inutiles. Évitez de repinger la même URL toutes les heures, d'envoyer des URL avant qu'elles ne soient accessibles, ou d'envoyer de gigantesques listes quand seulement quelques pages ont changé.

Erreurs courantes qui causent des délais d'indexation à grande échelle

Les délais d'indexation ne sont souvent pas un problème du moteur ; ils sont souvent auto-infligés. L'objectif est simple : facilitez la découverte de vos meilleures URL et rendez difficile le gaspillage de temps sur le reste.

Un piège fréquent est de produire en masse des pages qui vous semblent différentes, mais pas pour un crawler. Si des centaines de pages se contentent de remplacer un nom de ville, un adjectif produit ou quelques phrases, elles peuvent être traitées comme des quasi-duplications. Les crawlers peuvent ralentir, indexer moins de pages, ou choisir une version différente de celle que vous voulez.

Un autre tueur de crawl budget est la croissance incontrôlée des URL. Filtres facettés, recherche interne, pages de tag, archives calendrier et paramètres de suivi peuvent se multiplier en milliers d'URL crawlables. Même si elles ne font pas de mal, elles concurrencent les nouveaux contenus.

Erreurs les plus fréquentes :

- Publier en masse des pages très similaires sans valeur unique.

- Laisser tags, filtres, recherche interne et paramètres générer des variations d'URL sans fin.

- Compter uniquement sur le sitemap, sans liens internes solides depuis des hubs pertinents.

- Inclure dans les sitemaps des URL redirigeantes, non-canoniques, bloquées ou en

noindex.

- Renommer ou déplacer des URL de façon répétée juste après lancement, créant des recrawls, redirections et signaux de duplication.

Exemple : un blog immobilier publie 500 guides de quartier en une semaine. Si chaque guide est surtout un template avec quelques phrases changées, et que le site expose en plus des combinaisons de filtres infinies (chambres, salles de bain, prix, tri), les crawlers peuvent s'égarer sur les filtres pendant que les guides restent invisibles.

La correction porte souvent moins sur faire plus que sur resserrer les signaux : liez les nouvelles pages depuis quelques pages catégorie fréquentées, gardez les sitemaps propres, et congelez les URL jusqu'à ce que les pages aient eu le temps d'être crawlées et stabilisées.

Une checklist rapide et étapes suivantes

Les petits problèmes s'additionnent vite à haut volume. Ces vérifications aident à empêcher les nouvelles URL de se retrouver coincées.

Checklist rapide de publication (par page)

- Atteignable et rapide : renvoie 200, pas de chaînes de redirection, pas d'erreurs serveur.

- Indexable : pas de

noindex accidentel, pas de règles robots bloquantes, pas derrière une authentification.

- Canonical propre : pointe vers l'URL finale correcte (pas staging, pas une URL paramétrée).

- Découvrable : au moins un lien interne pertinent depuis une page indexée.

- Incluse dans votre sitemap : présente dans le sitemap XML approprié, avec un

lastmod correct et sans doublons.

Si l'un de ces points échoue, corrigez-le avant de publier davantage. Sinon, vous créez un arriéré où les crawlers revisitent les mauvaises URL.

Une routine hebdomadaire simple (15–30 minutes)

Choisissez un jour par semaine pour un nettoyage léger :

- Échantillonnez quelques nouvelles URL et confirmez qu'elles sont crawlées et indexées.

- Retirez des sitemaps les URL redirigeantes, canoniques vers une autre page, en

noindex ou en erreur.

- Surveillez les pics d'erreurs 5xx, les temps de réponse lents et la croissance des redirections.

- Supprimez les pages de tag maigres, les doublons et les pages paramétrées qui ne méritent pas d'être crawlées.

Si votre équipe copie des URL dans des tableaux, édite les sitemaps à la main et envoie des requêtes d'indexation manuellement, l'automatisation est souvent le tournant. Certaines équipes utilisent un système comme GENERATED (generated.app) pour générer et polir du contenu, garder les sitemaps à jour, et envoyer des pings IndexNow via une API lors du flux de publication, afin que le processus reste cohérent à mesure que la production augmente.