Pourquoi les nouvelles pages ne sont pas trouvées immédiatement

L'indexation signifie qu'un moteur de recherche a découvert votre page, l'a visitée et l'a stockée pour qu'elle puisse apparaître dans les résultats. La publication rend simplement une page disponible sur votre site. Elle ne l'intègre pas automatiquement dans la base de données d'un moteur de recherche.

Les nouvelles pages restent souvent invisibles pendant des jours parce que les crawlers fonctionnent selon leurs propres calendriers. Ils ont des milliards d'URL à parcourir, donc ils priorisent ce qui semble important et revisitent les sites selon des signaux passés comme la fréquence de publication, la qualité globale du site, la vitesse du serveur et si les visites précédentes ont trouvé des mises à jour pertinentes.

La découverte peut aussi échouer pour des raisons simples. La page peut ne pas être encore liée nulle part, votre sitemap peut ne pas avoir été traité, ou le crawler peut rencontrer un obstacle. Un petit problème, comme une balise noindex, une règle dans robots.txt, une chaîne de redirections ou des réponses lentes, peut retarder l'indexation même lorsque le contenu est de qualité.

Ce que vous pouvez contrôler se résume généralement à quelques bases :

- Facilitez l'accès à la page depuis d'autres pages pertinentes de votre site.

- Gardez l'URL stable après la publication.

- Évitez les blocages accidentels (robots.txt) et le

noindex involontaire.

- Assurez-vous que l'URL canonique pointe vers la page elle-même.

Ce que vous ne pouvez pas contrôler entièrement, c'est le timing. Même avec une configuration propre, les moteurs peuvent attendre, surtout pour des sites ou pages tout neufs ou pour des pages qui ressemblent beaucoup à ce qui est déjà indexé.

La rapidité importe surtout quand le timing est crucial : une page de vente, un article d'actualité lié à un événement, une mise à jour de prix importante ou la correction d'une page cassée. Pour du contenu evergreen, quelques jours changent rarement le résultat.

Exemple : vous publiez un nouvel article « how-to » un mardi. S'il n'est accessible que via une page de catégorie enfouie et que votre page d'accueil ne le lie pas, les crawlers peuvent ne le trouver qu'à leur prochaine visite de routine. Un lien interne clair et un signal de mise à jour rapide peuvent transformer « peut-être la semaine prochaine » en « beaucoup plus tôt ».

Un sitemap XML est un fichier qui répertorie les URL que vous souhaitez que les moteurs de recherche découvrent. Pensez-y comme un annuaire : il indique aux crawlers ce qui existe et parfois quand cela a été modifié pour la dernière fois.

Un sitemap est une suggestion, pas une commande. Il peut aider les moteurs à trouver et revisiter des pages, mais il ne garantit pas l'indexation. Si un crawler juge qu'une page est de faible qualité, dupliquée, bloquée ou qu'elle ne vaut pas la peine d'être explorée pour le moment, il peut l'ignorer.

La plupart des sitemaps incluent une URL plus quelques champs optionnels :

- loc : l'URL de la page (le seul champ réellement requis).

- lastmod : quand la page a été modifiée de façon significative.

- priority et changefreq : souvent ignorés, donc n'y comptez pas.

La conclusion pratique : les sitemaps sont excellents pour l'exhaustivité. Ils aident les moteurs à comprendre l'ensemble des pages importantes de votre site, y compris les pages anciennes ou profondes. Ils sont moins efficaces lorsque votre principal besoin est « je viens de publier ça, vérifiez maintenant ».

Dans un flux de travail sain, le sitemap se met automatiquement à jour lors d'une publication, d'une déspublication ou d'une modification de page. Si vous publiez via une API ou une architecture headless, assurez-vous que le sitemap est généré à partir de la même source de vérité que vos pages en ligne, afin de ne pas lister des URL qui renvoient 404 ou d'oublier des pages toutes neuves.

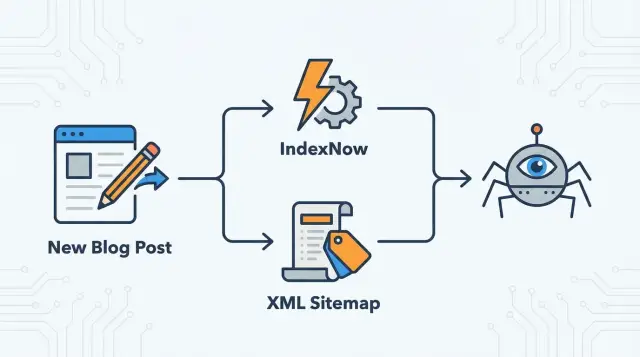

IndexNow renverse le modèle. Au lieu d'attendre qu'un crawler découvre les changements de lui-même, vous notifiez les moteurs supportés dès qu'une page est ajoutée, mise à jour ou supprimée.

Vous envoyez une petite notification qui dit, en substance : « Cette URL a changé. Merci de la recrawler. » Vous n'envoyez pas le contenu de la page et vous ne garantissez pas l'indexation. Vous accélérez simplement le moment où le moteur apprend qu'il y a eu un changement.

IndexNow fonctionne mieux quand vous le déclenchez juste après que la page mise à jour est en ligne et renvoie une réponse de succès normale. Si vous notifiez trop tôt (alors que la page est cassée ou pas complètement déployée), vous pouvez déclencher un recrawl rapide d'une mauvaise version.

IndexNow est un signal fort, mais il ne remplace pas une bonne structure de site. Les moteurs s'appuient toujours sur les liens internes, une navigation cohérente, des canonicals corrects et l'utilité globale pour décider d'indexer et de classer une page.

Pensez à IndexNow comme à une sonnette, pas à une carte.

Un sitemap XML est l'inventaire de votre site. C'est l'endroit fiable où les moteurs peuvent vérifier l'ensemble des pages que vous jugez importantes, même si ces pages sont anciennes, peu liées ou enfouies dans la navigation.

IndexNow est un signal d'alerte. Il signale une URL spécifique qui a été ajoutée, mise à jour ou supprimée afin qu'un crawler puisse venir plus tôt au lieu d'attendre le prochain cycle de crawl.

Utilisés ensemble, ils couvrent les deux besoins :

- Les sitemaps aident les moteurs à trouver tout ce qui compte.

- IndexNow les aide à remarquer ce qui a changé aujourd'hui.

Règle simple :

- Gardez un sitemap propre contenant uniquement des URL canoniques et indexables.

- Notifiez IndexNow lorsqu'une page est nouvellement publiée, modifiée de façon significative ou supprimée.

Lors de changements plus importants, ils se complètent aussi. Si vous renommez un slug, le sitemap aide les moteurs à apprendre le nouvel ensemble d'URL sur tout le site, tandis qu'IndexNow peut rapidement signaler que l'ancienne URL est supprimée et que la nouvelle est ajoutée.

Avant de commencer : vérifications rapides à effectuer

Tout cela ne sert à rien si vos pages ne sont pas réellement éligibles au crawl et à l'indexation. Les moteurs peuvent recevoir le signal et quand même ignorer la page si elle renvoie le mauvais statut, est bloquée ou pointe ailleurs.

Commencez par les bases. Chaque URL que vous voulez indexer doit être accessible publiquement, se charger rapidement et renvoyer un code 200 propre. Si elle renvoie une redirection, un 404 ou une erreur serveur, vous envoyez les crawlers dans une impasse. Confirmez aussi que la page n'est pas derrière une connexion, un blocage géographique ou une protection anti-bot trop stricte.

Les règles robots sont un bloqueur silencieux courant. Une ligne dans robots.txt peut stopper le crawl, et une meta robots ou un en-tête HTTP peut empêcher l'indexation même si le crawl est autorisé. Vérifiez le HTML rendu pour un noindex, et confirmez que robots.txt n'interdit pas le dossier où se trouvent vos nouveaux contenus.

Les canonicals et les redirections peuvent aussi perturber les crawlers. Si un nouveau post a une balise canonique pointant vers une URL différente (ou vers la page d'accueil), les moteurs peuvent le considérer comme un duplicata et s'abstenir de l'indexer.

Les liens internes restent importants, même si vous utilisez IndexNow. Une notification n'explique pas le contexte ni l'importance. Des liens depuis des pages déjà crawlées aident les moteurs à comprendre de quoi parle la nouvelle page et où elle s'insère.

Plan de déploiement simple pour accélérer l'indexation après publication

Considérez les sitemaps XML comme votre base toujours active et IndexNow comme la notification rapide pour les vrais changements.

-

Nettoyez votre sitemap. N'y listez que les pages que vous souhaitez vraiment indexer : statut 200, canonique vers elles-mêmes et non bloquées par robots.txt ou noindex. Écartez les URL à faible valeur (résultats de recherche internes, pages avec paramètres, pages de tags fines que vous ne voulez pas dans les résultats).

-

Automatisez les mises à jour du sitemap. Lorsqu'une page est publiée, modifiée ou supprimée, le sitemap doit le refléter rapidement. Sur de grands sites, scinder en plusieurs sitemaps (posts, actualités, glossaire) peut faciliter le repérage des changements.

-

Ajoutez IndexNow, mais avec modération. Automatisez les soumissions depuis l'endroit où vous publiez le contenu (un webhook de publication est un déclencheur courant). Ne notifiez que pour des changements qui importent réellement aux utilisateurs.

-

Définissez des déclencheurs simples. Soumettez IndexNow pour :

- Les nouvelles pages

- Les mises à jour significatives (titre, contenu principal, données structurées)

- Les suppressions

Ignorez les fautes de frappe et les petites modifications de formatage.

Ensuite, faites un point hebdomadaire pendant un mois. Vous cherchez surtout moins de retards et moins de surprises d'indexation, pas des changements instantanés de classement.

Erreurs courantes qui gaspillent le crawl et ralentissent l'indexation

La plupart des délais d'indexation sont auto-infligés. Les moteurs ne peuvent consacrer qu'un temps de crawl limité à votre site. Si vous envoyez des signaux désordonnés, ils apprennent à moins vous faire confiance.

Le plus grand gaspillage de temps est la soumission d'URL qui ne peuvent pas être indexées : pages bloquées par robots.txt, pages avec noindex, ou pages qui canonisent vers ailleurs. Il en va de même pour notifier IndexNow pour des URL qui redirigent immédiatement.

Un autre problème fréquent est la sur-notification. IndexNow n'est pas « plus rapide si je le spamme ». Renvoyer la même URL sans changement notable apprend aux moteurs à ignorer le signal.

Les sitemaps se polluent aussi avec des URL dupliquées, surtout des variantes avec paramètres (tri, filtrage, tracking). Les crawlers perdent du temps sur des duplicatas au lieu de se concentrer sur les pages nouvelles ou améliorées.

Enfin, faites attention au lastmod. Si chaque URL montre toujours la date du jour, les crawlers cessent de lui faire confiance. Mettez à jour lastmod uniquement quand le contenu principal change.

Scénario exemple : un petit blog qui publie chaque semaine

Imaginez un petit blog qui publie cinq nouveaux posts chaque semaine et rafraîchit environ 10 anciens posts par mois.

Un rythme propre ressemble à ceci :

- À la publication : notifiez IndexNow pour l'URL du nouvel article.

- Lors d'une modification majeure : notifiez IndexNow pour l'URL modifiée.

- Lors d'une modification mineure : ne faites rien.

- En continu : gardez le sitemap XML précis et à jour.

Si vous publiez des pages liées qui changent réellement (par exemple, une page de catégorie qui liste maintenant le nouveau post), vous pouvez les notifier aussi, mais limitez-vous.

Les premiers signes « positifs » sont pratiques :

- Les nouvelles URL apparaissent dans les outils d'indexation en quelques jours.

- L'activité de crawl devient plus régulière après les jours de publication.

- Les posts mis à jour sont recrawlés plus tôt après des modifications importantes.

Si rien ne change, cherchez une sortie sitemap obsolète, des blocages robots ou noindex, un maillage interne faible, ou trop de notifications à faible valeur.

Liste de contrôle rapide : votre configuration d'indexation en 5 minutes

Juste après la publication (ou après un déploiement), vérifiez rapidement les points suivants :

- Indexable et canonique vers elle-même : la balise canonique pointe vers la même URL (ni vers la page d'accueil, ni vers une page de catégorie).

- Non bloquée : pas de

noindex dans la meta robots ou les en-têtes HTTP, et robots.txt autorise le chemin.

- Réponse propre : renvoie 200 et est accessible publiquement (pas de mur de connexion, pas d'état d'erreur).

- Sitemap fidèle : la nouvelle URL apparaît rapidement ; les redirections, 404 et URL non-canoniques ne sont pas listées.

- IndexNow uniquement pour les changements significatifs : nouvelles pages, vraies mises à jour et suppressions.

Prochaines étapes : commencez petit, mesurez, puis automatisez

Commencez par un seul jalon : les nouvelles pages uniquement. Les nouvelles URL sont le test le plus clair parce qu'il n'y a pas d'historique pour brouiller les résultats. Une fois cela stabilisé, étendez aux mises à jour majeures et aux suppressions.

Tenez un journal léger (même un simple tableur) avec l'URL, la date de publication, si vous avez utilisé sitemap/IndexNow/les deux, et la date de découverte et d'indexation. Vérifiez les tendances chaque semaine.

Si la plomberie est correcte et que certaines pages restent lentes, la cause est généralement la page elle-même ou sa façon d'être connectée. Concentrez-vous sur une intention de recherche claire par page, ajoutez au moins un lien interne solide depuis une page déjà crawlée et évitez les quasi-duplications.

Si vous voulez automatiser davantage, une plateforme comme GENERATED (generated.app) peut aider à relier la publication de contenu aux signaux d'indexation comme IndexNow et à la génération de sitemaps. L'automatisation fait gagner du temps, mais dépend toujours des mêmes fondamentaux : URL accessibles, canonicals corrects et signaux de crawl propres.