Warum neue Seiten nicht sofort gefunden werden

Indexierung bedeutet, dass eine Suchmaschine deine Seite entdeckt, besucht und gespeichert hat, damit sie in den Ergebnissen erscheinen kann. Veröffentlichen macht eine Seite nur auf deiner Site verfügbar. Es führt nicht automatisch dazu, dass sie in der Datenbank einer Suchmaschine landet.

Neue Seiten bleiben oft Tage lang unsichtbar, weil Crawler nach eigenen Zeitplänen arbeiten. Sie haben Milliarden von URLs zu durchsuchen, priorisieren, was wichtig erscheint, und besuchen Sites basierend auf früheren Signalen wie Veröffentlichungsfrequenz, Gesamtqualität der Site, Servergeschwindigkeit und ob frühere Besuche lohnende Updates gefunden haben.

Die Entdeckung kann auch an einfachen Dingen scheitern. Die Seite ist vielleicht noch nirgends verlinkt, deine Sitemap wurde noch nicht verarbeitet, oder der Crawler trifft auf einen Blocker. Ein kleines Problem, wie ein noindex-Tag, eine Regel in robots.txt, eine Weiterleitungskette oder langsame Antworten, kann die Indexierung verzögern — selbst wenn der Inhalt stark ist.

Was du kontrollieren kannst, lässt sich meist auf ein paar Basics reduzieren:

- Mach die Seite leicht erreichbar von anderen relevanten Seiten auf deiner Site.

- Halte die URL nach der Veröffentlichung stabil.

- Vermeide versehentliche Blocks (

robots.txt) und unbeabsichtigte noindex-Tags.

- Stelle sicher, dass die kanonische URL auf die Seite selbst zeigt.

Was du nicht vollständig kontrollieren kannst, ist das Timing. Selbst bei sauberer Konfiguration können Suchmaschinen warten, besonders bei brandneuen Sites oder Seiten, die sehr ähnlich zu bereits indexiertem Inhalt aussehen.

Schnelligkeit ist vor allem dann wichtig, wenn Timing eine Rolle spielt: eine Verkaufs-Landingpage, ein News-Beitrag zu einem Ereignis, eine kritische Preisaktualisierung oder die Behebung einer zuvor defekten Seite. Bei Evergreen-Inhalten ändern ein paar Tage selten das Ergebnis.

Beispiel: Du veröffentlichst am Dienstag einen neuen How-to-Artikel. Wenn er nur über eine versteckte Kategorieseite erreichbar ist und deine Startseite nicht darauf verlinkt, finden Crawler ihn möglicherweise erst beim nächsten Routinebesuch. Ein klarer interner Link und ein deutliches Update-Signal können aus „vielleicht nächste Woche“ ein „viel früher“ machen.

Wie XML-Sitemaps funktionieren

Eine XML-Sitemap ist eine Datei, die die URLs auflistet, die du möchtest, dass Suchmaschinen entdecken. Stell sie dir als Verzeichnis vor: Sie sagt Crawlern, was existiert und manchmal, wann es zuletzt geändert wurde.

Eine Sitemap ist ein Hinweis, kein Befehl. Sie kann Suchmaschinen helfen, Seiten zu finden und wieder zu besuchen, garantiert aber keine Indexierung. Wenn ein Crawler eine Seite für von geringer Qualität, dupliziert, blockiert oder derzeit nicht ressourcenwert hält, kann er sie ignorieren.

Die meisten Sitemaps enthalten eine URL plus ein paar optionale Felder:

- loc: die Seiten-URL (das einzig wirklich erforderliche Feld).

- lastmod: wann sich die Seite inhaltlich geändert hat.

- priority und changefreq: werden oft ignoriert, verlasse dich nicht darauf.

Die praktische Schlussfolgerung: Sitemaps sind hervorragend für Vollständigkeit. Sie helfen Suchmaschinen, die gesamte Menge wichtiger Seiten deiner Site zu verstehen, auch ältere oder tief verschachtelte Seiten. Sie sind weniger effektiv, wenn dein Hauptbedarf lautet: „Ich habe das gerade veröffentlicht, bitte prüft es jetzt.“

In einem gesunden Workflow aktualisiert sich die Sitemap automatisch, wenn du eine Seite veröffentlichst, zurückziehst oder änderst. Wenn du per API oder in einem Headless-Setup veröffentlichst, stell sicher, dass die Sitemap aus derselben Quelle der Wahrheit generiert wird wie deine Live-Seiten, damit du keine URLs listest, die 404 zurückgeben, oder brandneue verpasst.

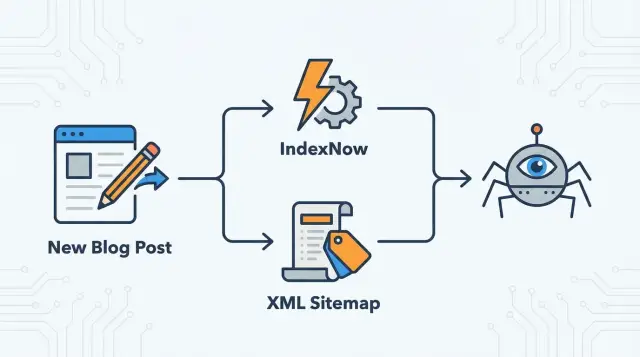

Wie IndexNow funktioniert und was es Suchmaschinen sagt

IndexNow dreht das Modell um. Anstatt darauf zu warten, dass ein Crawler Änderungen selbst entdeckt, benachrichtigst du unterstützte Suchmaschinen sofort, wenn eine Seite hinzugefügt, aktualisiert oder entfernt wurde.

Du sendest eine kleine Benachrichtigung, die im Wesentlichen sagt: „Diese URL hat sich geändert. Bitte crawlt sie nach.“ Du sendest keinen Seiteninhalt und garantierst auch keine Indexierung. Du beschleunigst den Moment, in dem die Suchmaschine erfährt, dass sich etwas geändert hat.

IndexNow funktioniert am besten, wenn du es direkt auslöst, nachdem die aktualisierte Seite live ist und einen normalen Erfolgscode zurückgibt. Wenn du zu früh benachrichtigst (während die Seite fehlerhaft oder nicht vollständig deployed ist), kannst du ein schnelles Nachcrawlen einer schlechten Version auslösen.

IndexNow ist ein starkes Signal, ersetzt aber keine gute Seitenstruktur. Suchmaschinen verlassen sich weiterhin auf interne Links, konsistente Navigation, korrekte Canonicals und den allgemeinen Nutzwert, um zu entscheiden, ob eine Seite indexiert und gerankt wird.

Denke an IndexNow als Türklingel, nicht als Karte.

Wann welches Werkzeug nutzen — und wie sie zusammenarbeiten

Eine XML-Sitemap ist das Inventar deiner Site. Sie ist der verlässliche Ort, an dem Suchmaschinen nachsehen können, welche Seiten du für wichtig hältst, selbst wenn diese Seiten alt, selten verlinkt oder tief in der Navigation vergraben sind.

IndexNow ist der Hinweis von heute. Es markiert eine bestimmte URL, die hinzugefügt, aktualisiert oder entfernt wurde, damit ein Crawler früher kommt, statt auf den nächsten Crawl-Zyklus zu warten.

Zusammen verwendet, decken sie beide Bedürfnisse ab:

- Sitemaps helfen Suchmaschinen, alles Wichtige zu finden.

- IndexNow hilft ihnen, zu bemerken, was sich heute geändert hat.

Eine einfache Faustregel:

- Halte eine saubere Sitemap mit nur kanonischen, indexierbaren URLs.

- Benachrichtige IndexNow, wenn eine Seite neu veröffentlicht, inhaltsreich aktualisiert oder entfernt wurde.

Bei größeren Änderungen ergänzen sie sich ebenfalls. Wenn du einen Slug umbenennst, hilft die Sitemap Suchmaschinen, die neue Menge an URLs auf der gesamten Site zu lernen, während IndexNow die alte URL schnell als entfernt und die neue als hinzugefügt markieren kann.

Bevor du startest: Kurze Anforderungen zum Prüfen

All das hilft nicht, wenn deine Seiten überhaupt nicht zum Crawlen und Indexieren geeignet sind. Suchmaschinen können das Signal erhalten und die Seite trotzdem überspringen, wenn sie den falschen Status liefert, blockiert ist oder irgendwohin verweist.

Beginne mit den Basics. Jede URL, die du indexiert haben möchtest, sollte öffentlich zugänglich sein, schnell laden und einen sauberen 200-Statuscode zurückgeben. Wenn sie eine Weiterleitung, 404 oder Serverfehler zurückgibt, schickst du Crawler in eine Sackgasse. Bestätige außerdem, dass die Seite nicht hinter Login, Geo-Block oder aggressivem Bot-Schutz steckt.

Robots-Regeln sind ein häufiger stiller Blocker. Eine Zeile in robots.txt kann das Crawlen stoppen, und ein Meta-Robots-Tag oder HTTP-Header kann die Indexierung verhindern, selbst wenn Crawlen erlaubt ist. Prüfe das gerenderte HTML auf noindex und vergewissere dich, dass robots.txt den Ordner, in dem neue Inhalte liegen, nicht disallowt.

Canonicals und Weiterleitungen können Crawler ebenfalls verwirren. Wenn ein neuer Beitrag ein Canonical auf eine andere URL (oder die Startseite) setzt, kann die Suchmaschine ihn als Duplikat behandeln und die Indexierung überspringen.

Interne Links sind weiterhin wichtig, auch wenn du IndexNow nutzt. Eine Benachrichtigung erklärt keinen Kontext oder die Relevanz. Links von bereits gecrawlten Seiten helfen Suchmaschinen zu verstehen, worum es auf der neuen Seite geht und wo sie in deiner Site einzuordnen ist.

Einfacher Rollout-Plan, um die Indexierung nach der Veröffentlichung zu beschleunigen

Behandle XML-Sitemaps als dein immer aktives Baseline-Tool und IndexNow als das Schnellbenachrichtigungs-Tool für echte Änderungen.

-

Sitemap aufräumen. Liste nur Seiten, die du tatsächlich indexiert haben willst: 200-Status, self-canonical und nicht durch robots.txt oder noindex blockiert. Halte URLs mit geringem Wert draußen (interne Suchergebnisse, Parameterseiten, dünne Tag-Seiten, die du nicht in der Suche haben willst).

-

Sitemap-Updates automatisieren. Wenn du veröffentlichst, bearbeitest oder entfernst, sollte die Sitemap dies schnell widerspiegeln. Bei größeren Sites kann das Aufteilen in mehrere Sitemaps (z. B. Posts, News, Glossar) Updates leichter erkennbar machen.

-

IndexNow hinzufügen, aber gezielt. Automatisiere Einreichungen vom gleichen Ort, an dem du Inhalte veröffentlichst (ein Publish-Webhook ist ein häufiger Auslöser). Benachrichtige nur bei Änderungen, die einem Suchenden wichtig wären.

-

Einfache Trigger definieren. Sende IndexNow für:

- Neue Seiten

- Bedeutende Updates (Titel, Haupttext, strukturierte Daten)

- Löschungen

Überspringe Tippfehler und winzige Formatierungsänderungen.

Überprüfe dann wöchentlich für einen Monat. Du suchst hauptsächlich nach weniger Verzögerungen und weniger Indexierungsüberraschungen, nicht nach sofortigen Rankings.

Häufige Fehler, die Crawlressourcen verschwenden und die Indexierung verlangsamen

Die meisten Indexierungsverzögerungen sind selbst verschuldet. Suchmaschinen haben nur begrenzt Crawl-Zeit für deine Site. Wenn du unordentliche Signale sendest, lernen sie dir weniger zu vertrauen.

Der größte Zeitverschwender ist das Einreichen von URLs, die nicht indexierbar sind: Seiten, die von robots.txt blockiert werden, Seiten mit noindex oder Seiten, die irgendwo anders kanonisiert sind. Dasselbe gilt für IndexNow-Benachrichtigungen für URLs, die sofort weiterleiten.

Ein weiteres häufiges Problem ist Über-Benachrichtigung. IndexNow wird nicht „schneller, wenn ich es spamme“. Dasselbe URL wiederholt ohne sinnvolle Änderung zu senden, trainiert Suchmaschinen darauf, das Signal zu ignorieren.

Sitemaps werden auch mit doppelten URLs verschmutzt, vor allem Parameter-Varianten (Sortierung, Filter, Tracking). Crawler verschwenden Zeit mit Duplikaten statt mit neuen oder verbesserten Seiten.

Schließlich: Vorsicht bei lastmod. Wenn jede URL stets das heutige Datum zeigt, verlieren Crawler das Vertrauen in das Feld. Aktualisiere lastmod nur, wenn sich der Hauptinhalt ändert.

Beispiel-Szenario: Ein kleiner Blog, der wöchentlich veröffentlicht

Stell dir einen kleinen Blog vor, der fünf neue Beiträge pro Woche veröffentlicht und etwa 10 ältere Beiträge pro Monat auffrischt.

Ein sauberer Rhythmus könnte so aussehen:

- Beim Veröffentlichen: IndexNow für die neue Beitrags-URL senden.

- Bei größeren Änderungen: IndexNow für die aktualisierte Beitrags-URL senden.

- Bei kleinen Änderungen: nichts tun.

- Laufend: Die XML-Sitemap aktuell und korrekt halten.

Wenn du verwandte Seiten veröffentlichst, die sich wirklich ändern (z. B. eine Kategorieseite, die jetzt den neuen Beitrag auflistet), kannst du diese auch benachrichtigen — aber halte es begrenzt.

Frühe „gute“ Zeichen sind praktisch:

- Neue URLs erscheinen innerhalb weniger Tage in Indexierungstools.

- Crawl-Aktivität wird nach Veröffentlichungstagen konstanter.

- Aktualisierte Beiträge werden nach größeren Änderungen schneller nachgecrawlt.

Wenn sich nichts ändert, suche nach veraltetem Sitemap-Output, robots- oder noindex-Blöcken, schwachen internen Verlinkungen oder zu vielen Benachrichtigungen mit geringem Wert.

Kurze Checkliste: Dein Indexierungs-Setup in 5 Minuten

Kurz nach dem Veröffentlichen (oder nach einem Deploy) prüfe die Basics:

- Indexierbar und self-canonical: das Canonical zeigt auf dieselbe URL (nicht auf die Startseite, nicht auf eine Kategorie-Seite).

- Nicht blockiert: kein

noindex in Meta-Robots oder HTTP-Headern, und robots.txt erlaubt den Pfad.

- Saubere Antwort: liefert 200 und ist öffentlich zugänglich (kein Login, kein Fehlerzustand).

- Sitemap stimmt mit der Realität überein: die neue URL erscheint schnell; Weiterleitungen, 404s und nicht-kanonische URLs sind nicht gelistet.

- IndexNow nur für sinnvolle Änderungen: neue Seiten, echte Updates und Löschungen.

Nächste Schritte: Klein anfangen, messen und dann automatisieren

Beginne mit einem Meilenstein: nur neue Seiten. Neue URLs sind der klarste Test, weil es keine Historie gibt, die die Ergebnisse verwässert. Wenn das stabil ist, erweitere auf größere Updates und Löschungen.

Führe ein leichtes Log (selbst ein einfaches Spreadsheet reicht) mit URL, Veröffentlichungsdatum, ob du Sitemap/IndexNow/beides genutzt hast und wann die Seite entdeckt und indexiert wurde. Prüfe wöchentlich auf Trends.

Wenn die Technik stimmt und einige Seiten trotzdem hinterherhinken, liegt die Ursache meist im Seiteninhalt oder in ihrer Einbindung. Konzentriere dich auf eine klare Suchintention pro Seite, füge mindestens einen starken internen Link von einer bereits gecrawlten Seite hinzu und vermeide nahe Duplikate.

Wenn du mehr automatisieren möchtest, kann eine Plattform wie GENERATED (generated.app) helfen, Publishing mit Indexierungs-Signalen wie IndexNow und Sitemap-Generierung zu verknüpfen. Automatisierung spart Zeit, hängt aber weiterhin von denselben Grundlagen ab: zugängliche URLs, korrekte Canonicals und saubere Crawl-Signale.